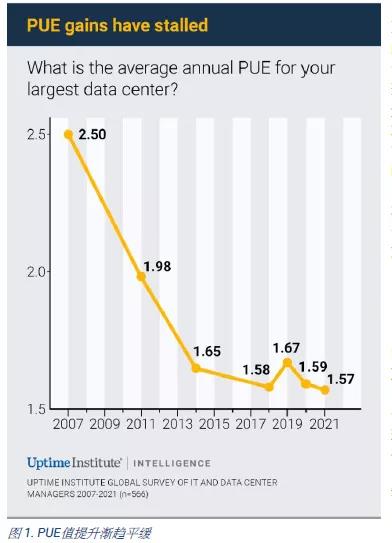

下图为2021年Uptime institute提供的全球数据中心PUE调研数据和中国数据中心的情况基本类似,对PUE数据分别针对新建机房和老旧机房的数据。

对于新建机房,机柜密度普遍在5~10Kw,机房PUE数据普遍都在1.3~1.6之间,和国内情况比较类似。目前国内5Kw以上机柜的机房,北京地区的运营PUE值普遍会低于1.3,上海和广州地区会高一些,一般会高于1.5。

调查了北京地区目前运营比较好的几个数据中心的情况(PUE=1.2~1.3),其运营数据主要体现在系统架构和运营控制两个层面。

系统架构层面核心主要以下几点:

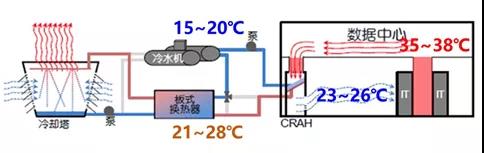

1、冷通道温度普遍设计在23~26℃,温度越高冷水机组效率越高,自然冷源利用时间越长。

2、非高密机房(机柜功率<8KW)采用列间空调可以明显提高PUE的运营效果。

列间空调自身运行功率约为房间级的一半。

列间空调风量平衡控制更加优秀,可以更好的提高供回水温差。

3、末端换热设备换热面积尽量增加30%,提高供回水温差。

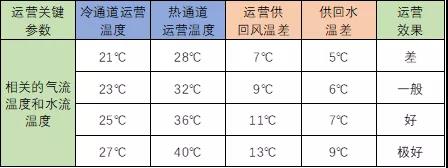

设计核心体现如下:

实际运营层面主要有以下几点:

1、尽量保证末端风量平衡,提高机组回风温度,从而提高系统的回水温度。

运营机房最好的回风温度是38℃,送回风温差约13℃(接近IT服务器进出风温差),运营出这个效果机房的PUE均在1.2以下,北京目前地区案例特别少。

运营机房普通比较好的回风温度是36℃,送回风温差约11℃。运营出这个效果机房的PUE约在1.22左右,北京目前地区案例比较少。

典型运营机房送回风温差保持在9~10℃,基本的全年PUE维持在1.3左右。

2、冷冻水供回水温度普通在5~8℃。运营最高的机房温差在8℃,普通在5℃左右,水泵能耗相差接近60%。

3、充分利用过度季节,由于系统和设备运行原因,系统过度季节控制特别难,某些项目通过特殊途径解决了这个问题。对于过度季节的解决方案,后续会有文章对此详细的论述。

运营核心体现如下:

对于老旧机房,Uptime institute提供的观点主要有如下两点:

1、对于老旧机房大规模的整改不太符合实际运行情况。最大的改造收益为空调末端气流组织改造:

完善气流的封闭措施,降低漏风、回流等冷热混合现象。

增加相应气流控制手段和风量监测,提高送风温度和供回风温差,降低末端风机的频率。

优化空调控制逻辑,提高空调末端供回水温度和温差。

2、完善冷冻水空调系统的控制逻辑:

合理控制水泵和冷却塔运行逻辑和运行参数。

增大自然冷源的利用时间。

优化系统过度季节的控制逻辑。

另外Uptime Institute报告中还指出:随着数据中心设施的数量和规模迅速增长,招聘人员的速度,难以赶上新创造的就业机会。基础运维、保养人员严重短缺。

行业人员培训是目前明显的短板。针对此问题,目前急切需要解决如下几个问题:

1、标准化教材的编制工作:针对于基础运维人员,需要有针对性的教材,目前很多培训教材和现场实际严重脱节。

目前数据中心的运维和维保的基础人员主要为如下人员:

新毕业的职业教育学生:他们的理论基础和实际经验都非常欠缺,而且稳定性比较差。

年龄超过40岁,从当地商业或居民物业转业人员:此人员的稳定性和经验很好,但是缺乏数据中心知识的学习渠道和培训渠道。

2、建立理论和实践为一体的培训基地:数据中心目前越来越智能化和数字化,个人体力劳动工作越来越少。但是如何去保障数据中心的安全性和节能性,是一个理论和实际经验联系特别紧密的行业,需要有一套完整的、多课时、多层次的培训教材和培训基地。

文章声明

本文仅供大家学习参考,不得用于任何商业用途,文章内容未经网站英沣特书面授权,请勿转载。