独孤九剑第二剑

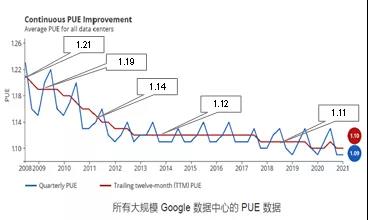

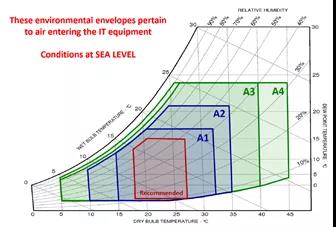

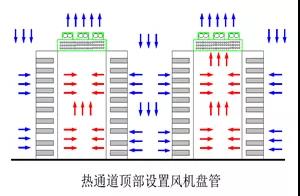

上述温度范围比我国设备运行温度范围高出很多,基本采用了年A1级服务器允许的温度范围。实际运行过程中,其气流组织和实景照片如下图所示。

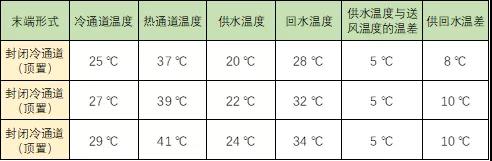

其具体的供回风参数与供回水温差的取值如下:

当室外温度合适时,室内温度控制会低于25℃。当夏季湿球温度高于25℃时,可以将送风温度调整至29℃,采用大温差(10℃)系统,空调系统将能全年利用自然冷源。

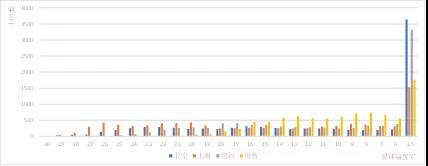

下图为全球四大中心城市(纽约、伦敦、北京、上海)全球湿球温度统计图,可以看出欧美整体气候比中国凉爽很多,基本高于25℃的湿球温度天气很少,而上海全年湿球温度高于25℃时间比例也不会超过15%,北京则不超过5%的时间。

因此数据中心如果在15%的时间内,系统供水温度保持在24℃,供回水温差保持在10℃的工况下,数据中心使用压缩机制冷开启时间将大大降低,从而最大程度上促进自然冷源的充分利用,就能在全球绝大部分区域,保障整个空调系统全年CLF值低于0.1。

可以根据当地气象条件,全年选择适当比例的时间(低于15%)内,将机房运行温度从允许值的27℃提升至29℃(国内某大厂有尝试),在服务器可靠性降低可忽略不计的情况下,能很大程度上增加数据中心自然冷源的利用。

根据国内气候特点,在全年有限比例(<15%)时间内,适当在推荐温度范围内(18~27℃),前进一小步(29℃),会给整个空调系统带来较大的变革。主要原因是此工作温度(29℃)、供回水温度(24~34℃)和全年最高湿球温度非常贴近,会造成空调系统明显能耗的降低。

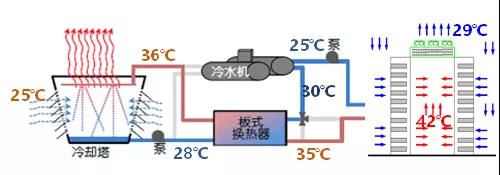

空调系统采用供水温度24℃,供回水温差10℃运行参数,当室外25℃湿球温度下,其运行参数如下所示:

从上述运行参数可以看出,在室外湿球温度25℃时,冷水机组依然只需要承担系统50%的冷负荷。在原有温湿度基础上突破一小步,带来的节能收益非常可观。另外通过大温差系统及良好的水力平衡控制系统,给整个空调系统节能运行带来很大程度上的节能。